Q. PCとサーバーって違うんでしょ?

A. 同じです。

皆さんは自宅で使っている PCの蓋を開けて中を見たことがあるでしょうか。

昨今はノートPC全盛なので、そうも行かないケースが多いですね。

サーバーのお仕事をしようとしている人で、家ではデスクトップPCを使っているなら是非開けて中味を見て下さい。

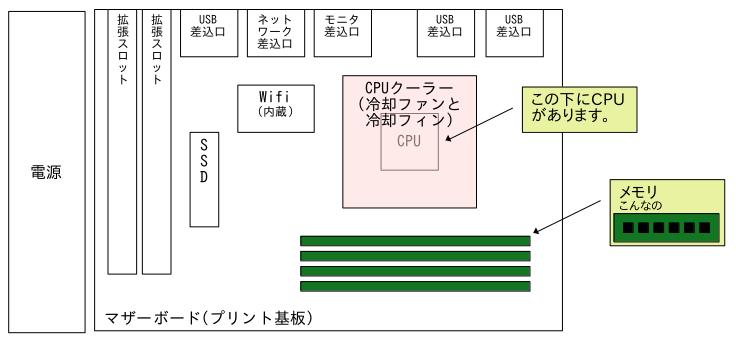

最近のは概ねこんな感じだと思います。

[上から見た図]

プリント基板の上に CPU(の上に大きな冷却フィンと冷却ファン)・メモリ、端っこに電源です。

一方のサーバーですが、写真は著作権の関係があるのでここには載せません。

検索すれば、これのようにいくらでも出てきますので、そちらを参照願います。

サーバーと言っても基本的には PCと同じ構成なんですが、違うのが以下の点です。

- 冷蔵庫のように大きなラックに入れるため薄くて長い箱になっている

ラックは 42台も入るのが多い - 細かい部品までPC部品よりも信頼性の高いものを使っている

基本的に稼働しっ放しにるすから - 部品を交換しやすく工夫してある

稼働中でも交換できるものもある - 部品が壊れても稼働し続けられるように同じ部品を複数搭載できる

- CPU(XEON)・メモリ(RDIMM)は信頼性の高いサーバー用のもの

規格が違って PCでは使えないし高い - CPUを複数積める

- 搭載できるメモリ量が PCと比べて非常に大きい

- 冷却性能が高い

その代わりうるさい - SSD/HDDを多く積めるのが普通

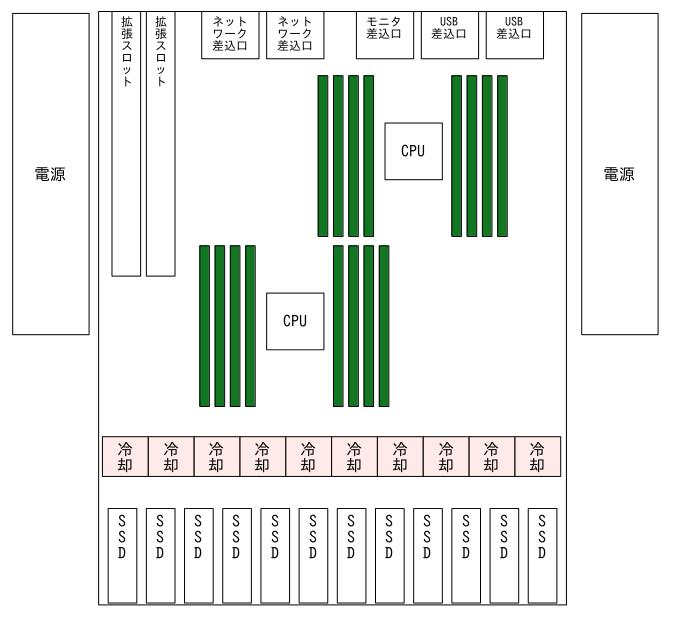

サーバーの蓋を開けて中を見るとこんな風になっています。

(本物とはちょっと違いますが概ねこんな構成)

[上から見た図]

電源も2つ入っていたりします。

あとはこれに外付けの大容量ストレージ(SSD/HDDが一杯入っていてハードウェアの機能として RAID構成になってる)を繋げていることが多いです。

PCとサーバーってハードウェア的にはこのように結構違うんですが、大枠でのコンピューターの仕組み(アーキテクチャ)としては同じで、インストールされる OSからはサイズは違うながらも同じようなものに見えます。

CPUコアという概念が無かった昔、CPUを 2つ積めるのはハイエンドなサーバーの特権でしたが、CPUチップ 1つに多数の CPUが載っている設計(メニーコア)の時代には PCとの違いが減ってきましたね。

乱暴に言ってしまうとサーバーとは単に連続稼働に向いた信頼性の高い PCです。

でも冷却は凄いですよ。

サーバーは24時間365日ずっと動きっ放しにするのが普通なので、データセンター(夏でも寒い・消防施設あり)という基本的に人がいない環境で動かすものなので、ゴォォォと大きな風切り音がします。

こんなのが何百台も同じ部屋(サーバールーム)にあるので、写真で見るイメージとは違ってサーバールームはうるさい。

最近はパブリッククラウドが流行りでサーバーに触れたことも無ければ見たことも無いサーバーエンジニアが多くなってきていますが、今でも「オンプレ」と呼ばれる現場では実際にサーバールームも職場になりますね。

先般千葉県に Googleのデータセンターがやってきましたが、あそこには大変な数の専用設計のサーバーが並んでいるはずです。

でも恐れることなかれで、サーバー機だからと言って OSから上の扱いはほとんど PCと変わりません。

仕事はデータセンターではなく基本はリモートでやりますんで、サーバーの所に行くのは壊れた時(吐)だけですから、ここでやっているような PCを使ってサーバーのお勉強をしても実地でちゃんと役に立ちます。

サーバーだけで発生するものってあるかな?と思い出してみますといくつかありました。

1.ネットワーク経由で使えるサーバー管理機能がある

私は HP(ヒューレットパッカード)のサーバーばかりでしたが、他のメーカーでもそれぞれに似た機能を持っています。

サーバーってリモートで使うのが基本なので、サーバーの電源を入れたり切ったりとか、OSがぶっ飛んだ時の画面とか、そういう時のためにサーバー機に物理的に繋がっているモニタ(コンソール)の画面をネットワーク経由で提供できるようになっています。

これは各社で全く統一されていないので、一つ一つ覚えなければなりません。

これは自分で買うでもしなければ自学はできませんけど、そんなに多機能でもないので大丈夫でしょう。

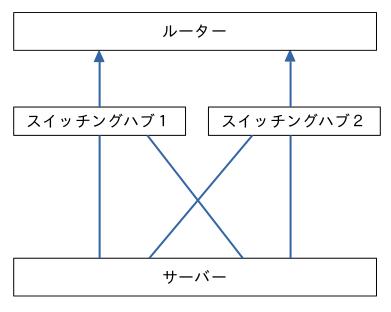

2.ネットワークの線も経路も冗長化する

サーバーには 4つもネットワークの口があったりします。

これはネット回線の障害(断線など)への対策で、複数のネットワーク線を 1つの線と見なす機能を使うのです。

HPサーバーでは「チーミング」って呼んでましたが、Linuxでは「ボンディング」って言ってたかな。

こんな風にネットワークケーブルをつなげるんですけど、これだけで 1台で 4つのネットワーク口が必要です。

ネットワークケーブルの敷設(4本必要とか)ではデータセンターの施設管理担当者と、スイッチングハブとの接続についてはネットワークの担当者と話をしなければなりません。

これも自学できないものですね。

3.電源も二重化

電源って結構頻繁に壊れます。

なのでサーバーでは 2つ入れて片肺でも稼働できるようになっていて、かつ稼働中に交換できるようになっています。

サーバーラックにくっついている電源タップは、データセンターのビルレベルで多系統に分かれた電源施設から分けた 2系統から取得されているので、2本の電源コードを同じ電源タップに挿してはいけません。

サーバーは 200Vが普通のアメリカで作られている関係で、電源ユニットは 200V用のものがデフォになっています。

最近は変わってるかもしれませんが、セータセンターの電圧が 200Vなのか 100Vなのか確認してそれにあったものを選択します。

==========

同じと謳っておきながら、結構違うか…。

物理的なハードウェアを扱う点での差異は当然ありますが、それは自宅のプライベート環境と仕事の本気環境との違いであって、サーバーエンジニアの仕事の本質ではないかなぁ、語弊があるかも知れませんけど。

最後に1つだけ未経験者にアドバイスを。

サーバールームに行くときは、夏場でも上着を持っていきましょう。(寒いよ)

オンプレのサーバー管理の本って無いですねぇ…

| 価格:1848円 |