ディスクを買ってきたらどうするかの話。

Ubuntuのマシンを作った後になって「もっとディスク欲しいな〜」ということはままあるかと思います。

ここで Windowsなら、買ってきたディスクを物理的に繋いでやれば勝手にドライブが増えてすぐに使えるようになるんですが Linuxではそうはいきません。

ここでは Linuxで物理ディスクの追加後にやる作業をやってみます。

1.前提・環境

ここでは VMware Workstation Pro(長いので以降は VMwareと書きます)で作った仮想マシンにインストールした Ubuntu Server 24.04を使います。

どこかでハードディスクを買ってきたことを模して、VMwareの仮想ハードディスクを追加します。

仮想ハードディスクと言っても Linux OSから見ると物理ディスクが増設されたのと同じなので参考にしてください。

この時代にはもう MBR(32bitの時代のディスクの管理方法で最大サイズが 2TBまで)でもないと思いますので、GPT(新しい規格)前提で進めます。

ではでは。

Ubuntu Serverのインストールについては「Ubuntu 24.04 Server インストール」に書いています。

以降はこれで作った仮想OSに対して操作をしていきます。

2.現状確認

Ubuntu Serverにはインストール時に 20GBの仮想ハードディスクを 1つ与えていますので、ハードディスク増設前に現在のディスクの状態を dfコマンド(report file system disk space usage)で見てみましょう。

subro@UbuntuServer2404:~$ df

Filesystem 1K-blocks Used Available Use% Mounted on

tmpfs 808364 1448 806916 1% /run

/dev/mapper/ubuntu--vg-ubuntu--lv 18631360 7133780 10525804 41% /

tmpfs 4041800 0 4041800 0% /dev/shm

tmpfs 5120 0 5120 0% /run/lock

/dev/sda2 1790136 189264 1491612 12% /boot

tmpfs 808360 12 808348 1% /run/user/1000

ピンク色のところがハードディスクが割り当てられている箇所になります。

ハードディスクを増設するため Ubuntu Serverをシャットダウンします。

subro@UbuntuServer2404:~$ sudo poweroff

シャットダウンが済んだら先に進みましょう。

3.ディスク増設

当然ながら本来の物理ディスクの増設であればここで PCケースを開いて〜って作業になりますので仕込みが終わったら 4に飛んで下さい。

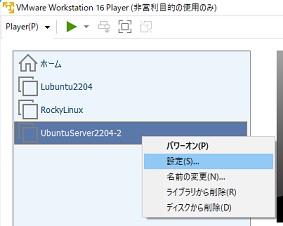

私の環境は VMwareの仮想OSですので VMwareのメニューで Ubuntu Serverの仮想マシンの上で右クリックするとメニューが出ますので、[設定]を選択します。

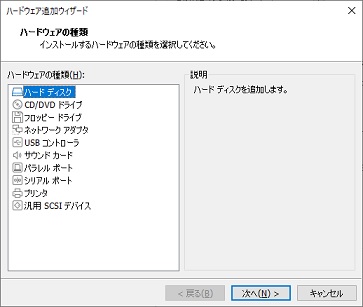

下の方にある追加を押します。

[ハードディスク]を選択して次へを押します。

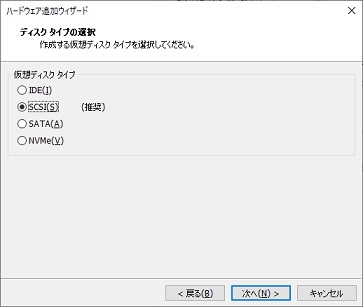

[SCSI]を選択して次へを押します。

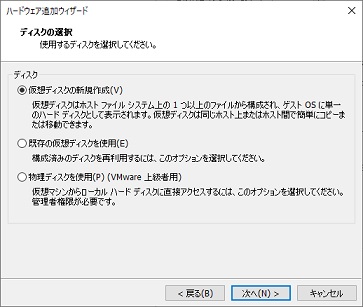

[仮想ディスクの新規作成]を選択して次へを押します。

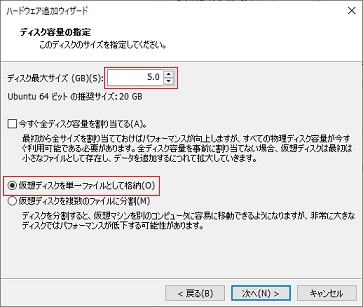

[ディスク最大サイズ]を入力し、[仮想ディスクを単一ファイルとして格納]を選択して次へを押します。

([今すぐ〜]は普段はチェックしていませんがここでは物理ディスクを追加したケースを模してあえてチェックを入れました。しかし後になって考えてみると大して意味はありませんでした。)

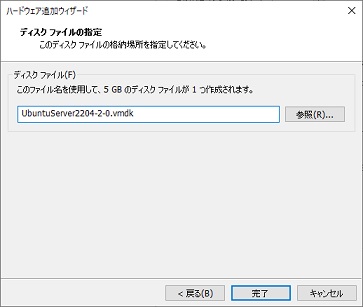

完了を押します。

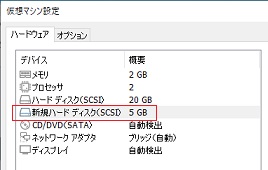

5GBの新規仮想ディスクができました。

OKを押します。

これで物理ディスクを増設したのと同じ効果になりますので Ubuntu Serverを立ち上げて下さい。

4.ロジカルボリューム

lsblkコマンド(list block devices)で新しいディスクを OSが認識していることを確認します。

subro@UbuntuServer2404:~$ lsblk

NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINTS

sda 8:0 0 20G 0 disk

├─sda1 8:1 0 1M 0 part

├─sda2 8:2 0 1.8G 0 part /boot

└─sda3 8:3 0 18.2G 0 part

└─ubuntu--vg-ubuntu--lv 252:0 0 18.2G 0 lvm /

sdb 8:16 0 5G 0 disk

sr0 11:0 1 1024M 0 rom

[sda] が OSがインストールされた 20GBのハードディスクで、

[sdb] という 2つ目のハードディスクが認識されていますね。

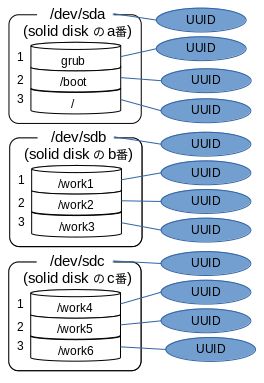

(sdは Solid Diskの略だったはずで、それの a番目と b番目という意味。Solidは多分 Floppy Diskに対しての固定ディスクということかと。)

でもファイルシステムとして使えるようにはなっていません。

ここから論理ボリュームというものを作っていきますが、論理ボリュームって何でしょうか。

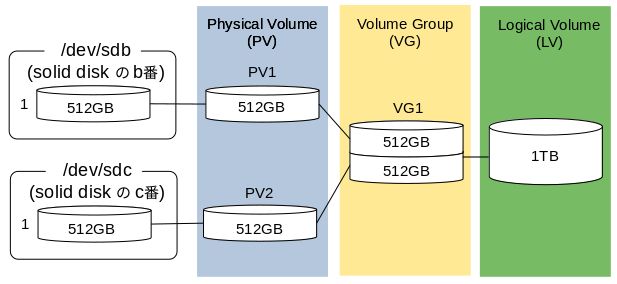

昔の UNIXの世界ではディスクの中の領域を直接ファイルシステムにマウントしていたのですが、物理ディスクのサイズよりより大きな領域が欲しいとか、RAIDを組みたいとかそういう要求が出てきました。

それに応じるため、OSからディスクへのアクセスの間にソフトウェアを噛ませて、OSからは 1つのディスクに見えているけど実体は複数のディスクから構成されている、そういう仕組みが作られました。

ディスクやその中に作られた領域を物理ボリュームと呼ぶのに対して、ソフトを介して「OSから 1つのディスクに見える」のが論理ボリュームです。

例えば小さなディスク(512GB)を 2つ使って大きなディスク(1TB)に見せる場合の構成はこんな感じです。

色の着いているところが間に噛んでいるソフトウェアの世界で、以下のような考え方です。

| PV | 物理ボリュームと 1:1 で紐付いている |

| VG | 複数の PVを 1つのディスクユニットとしてまとめたもの |

| LV | VGの中で切り分けられた領域(ここで切り分けてません) |

このように論理ボリュームという観念を間に挟むことによって、ディスクの本数やサイズなどに関係なく柔軟な構成を取ることができます。

では上の絵の左の方から右の方へと作業をしていきます。

ここでは 1つしかディスクを足していませんので絵とはちょっと違いますが、やることは同じです。

5.PV作成

Physical Volume(PV)を作ります。

作るというより、紐付け・名付け、そんな感じの作業です。

新規ディスクを領域に分割して、それぞれ別の PVにすることもできるのですが、5GBしかありませんし、1台 = 1PV で使うことが現実的にだと思いますので、ここでは分割はしないで 5GBを全部使います。

Linuxのように論理ボリュームを使うのが普通になっている OSでは追加する物理ディスクを分割することは余り無いと考えます。

pvcreateコマンド(Initialize physical volume(s) for use by LVM)を使います。

subro@UbuntuServer2404:~$ sudo pvcreate -v /dev/sdb

Wiping signatures on new PV /dev/sdb.

Set up physical volume for "/dev/sdb" with 10485760 available sectors.

Zeroing start of device /dev/sdb.

Writing physical volume data to disk "/dev/sdb".

Physical volume "/dev/sdb" successfully created.

新しい PVができました。

PVの情報を得てみましょう。

pvdisplayコマンド(Display various attributes of physical volume(s))を使います

subro@UbuntuServer2404:~$ sudo pvdisplay

--- Physical volume ---

PV Name /dev/sda3

VG Name ubuntu-vg

PV Size <18.23 GiB / not usable 3.00 MiB

Allocatable yes (but full)

PE Size 4.00 MiB

Total PE 4665

Free PE 0

Allocated PE 4665

PV UUID 35HoZS-aKFY-VO64-65HW-xqh0-nVNH-sM4T3l

"/dev/sdb" is a new physical volume of "5.00 GiB"

--- NEW Physical volume ---

PV Name /dev/sdb

VG Name

PV Size 5.00 GiB

Allocatable NO

PE Size 0

Total PE 0

Free PE 0

Allocated PE 0

PV UUID i1sadz-Rr89-lC1k-ldSO-ahB1-Ou6d-o5zLg6

下の段が新しい 5GBの PVで、 [/dev/sdb] という名前になりました。

==========

ここから以下 2つのコースに別れます。

- Aコース:既存の[/(ルート)]を拡張する

- Bコース:新しく領域を追加してマウントする

==========

Aコース 6./(ルート)のディスク領域確認

[/(ルート)]ディレクトリに割り当てられているディスク領域の情報を確認していきます。

dfコマンド(report file system space usage)から。

subro@UbuntuServer2404:~$ df

Filesystem 1K-blocks Used Available Use% Mounted on

tmpfs 808364 1444 806920 1% /run

/dev/mapper/ubuntu--vg-ubuntu--lv 18631360 7797640 9861944 45% /

tmpfs 4041804 0 4041804 0% /dev/shm

tmpfs 5120 0 5120 0% /run/lock

/dev/sda2 1790136 370912 1309964 23% /boot

tmpfs 808360 12 808348 1% /run/user/1000

[/dev/mapper/ubuntu--vg-ubuntu--lv]という(デバイス)ファイル管理されていることが分かりました。

[/(ルート))ディレクトリに割り当てられている LVの情報を確認します。

lvdisplayコマンド(Display information about a logical volume)を使います。

subro@UbuntuServer2404:~$ sudo lvdisplay /dev/mapper/ubuntu--vg-ubuntu--lv

--- Logical volume ---

LV Path /dev/ubuntu-vg/ubuntu-lv

LV Name ubuntu-lv

VG Name ubuntu-vg

LV UUID N4mojY-BscZ-ycAz-XcpS-EKTx-YOhv-Yf3Pi7

LV Write Access read/write

LV Creation host, time ubuntu-server, 2024-04-26 10:23:22 +0900

LV Status available

# open 1

LV Size 18.22 GiB

Current LE 4665

Segments 1

Allocation inherit

Read ahead sectors auto

- currently set to 256

Block device 252:0

[ubuntu-lv]という名前の LVで、[ubuntu-vg]という名前の VGからディスク領域を得ていました。

[LV Path] の [/dev/ubuntu-vg/ubuntu-lv] は後の作業で使いますので覚えておいてください。

[ubuntu-vg]VGの情報を確認します。

vgdisplayコマンド(Display volume group information)を使います。

subro@UbuntuServer2404:~$ sudo vgdisplay ubuntu-vg

--- Volume group ---

VG Name ubuntu-vg

System ID

Format lvm2

Metadata Areas 1

Metadata Sequence No 2

VG Access read/write

VG Status resizable

MAX LV 0

Cur LV 1

Open LV 1

Max PV 0

Cur PV 1

Act PV 1

VG Size 18.22 GiB

PE Size 4.00 MiB

Total PE 4665

Alloc PE / Size 4665 / 18.22 GiB

Free PE / Size 0 / 0

VG UUID 52gNrf-JZRq-mIPs-27aj-UHG8-QDWL-BWsooP

サイズに関して以下を覚えておきましょう。

| VG Size | VGのサイズ |

| PE Size | PE(Physical Extent)のサイズ このサイズ単位に割当が行われる |

| Alloc PE / Size | LVに割り当て済みの PE数とサイズ |

| Free PE / Size | LVに未割り当ての PE数とサイズ 今は 0 |

Aコース 7.VG拡張

[ubuntu-vg]VGに [/dev/sdb]PVを追加します。

vgextendコマンド(Add physical volumes to a volume group)を使います。

subro@UbuntuServer2404:~$ sudo vgextend ubuntu-vg /dev/sdb

Volume group "ubuntu-vg" successfully extended

追加されました。

[ubuntu-vg]VGの状態を確認します。

subro@UbuntuServer2404:~$ sudo vgdisplay ubuntu-vg

--- Volume group ---

VG Name ubuntu-vg

System ID

Format lvm2

Metadata Areas 2

Metadata Sequence No 3

VG Access read/write

VG Status resizable

MAX LV 0

Cur LV 1

Open LV 1

Max PV 0

Cur PV 2

Act PV 2

VG Size <23.22 GiB

PE Size 4.00 MiB

Total PE 5944

Alloc PE / Size 4665 / 18.22 GiB

Free PE / Size 1279 / <5.00 GiB

VG UUID 52gNrf-JZRq-mIPs-27aj-UHG8-QDWL-BWsooP

全体のサイズが増えて、[Free PE / Size]が 1,279個になりました。

Aコース 8.LV拡張・/(ルート)の拡張

[ubuntu-lv]LVに Free PEになっている 1,279個の PEを全て追加します。

lvextentコマンド(Add space to a logical volume)を使います。

コマンドオプションを2つ使います。

| -r | LV拡張と同時にファイルシステムとしての拡張も行う |

| -l+ | -l は出来上がり LVのサイズを指定するオプション + を加えると追加するサイズの指定になる |

コマンドオプションに「Free PEを全て使う」というのもあるんですが、今後柔軟に割当をできるようあえてそれは使いません。

subro@UbuntuServer2404:~$ sudo lvextend -r -l+1279 /dev/ubuntu-vg/ubuntu-lv

Size of logical volume ubuntu-vg/ubuntu-lv changed from 18.22 GiB (4665 extents) to <23.22 GiB (5944 extents).

Logical volume ubuntu-vg/ubuntu-lv successfully resized.

resize2fs 1.47.0 (5-Feb-2023)

Filesystem at /dev/mapper/ubuntu--vg-ubuntu--lv is mounted on /; on-line resizing required

old_desc_blocks = 3, new_desc_blocks = 3

The filesystem on /dev/mapper/ubuntu--vg-ubuntu--lv is now 6086656 (4k) blocks long.

[ubuntu-lv]LVの拡張ができました。

改めて [ubuntu-vg]VGの情報を見てみましょう。

subro@UbuntuServer2404:~$ sudo vgdisplay ubuntu-vg

--- Volume group ---

VG Name ubuntu-vg

System ID

Format lvm2

Metadata Areas 2

Metadata Sequence No 4

VG Access read/write

VG Status resizable

MAX LV 0

Cur LV 1

Open LV 1

Max PV 0

Cur PV 2

Act PV 2

VG Size <23.22 GiB

PE Size 4.00 MiB

Total PE 5944

Alloc PE / Size 5944 / <23.22 GiB

Free PE / Size 0 / 0

VG UUID 52gNrf-JZRq-mIPs-27aj-UHG8-QDWL-BWsooP

[Free PE / Size] が 0になりました。

[ubuntu-lv]LVの情報を見てみます。

subro@UbuntuServer2404:~$ sudo lvdisplay /dev/mapper/ubuntu--vg-ubuntu--lv

--- Logical volume ---

LV Path /dev/ubuntu-vg/ubuntu-lv

LV Name ubuntu-lv

VG Name ubuntu-vg

LV UUID N4mojY-BscZ-ycAz-XcpS-EKTx-YOhv-Yf3Pi7

LV Write Access read/write

LV Creation host, time ubuntu-server, 2024-04-26 10:23:22 +0900

LV Status available

# open 1

LV Size <23.22 GiB

Current LE 5944

Segments 2

Allocation inherit

Read ahead sectors auto

- currently set to 256

Block device 252:0

[LV Size] が 23GBになりました。(作業前は 18GB)

ファイルシステとしてはどうか。

subro@UbuntuServer2404:~$ df

Filesystem 1K-blocks Used Available Use% Mounted on

tmpfs 808360 1452 806908 1% /run

/dev/mapper/ubuntu--vg-ubuntu--lv 23787904 7134892 15472836 32% /

tmpfs 4041796 0 4041796 0% /dev/shm

tmpfs 5120 0 5120 0% /run/lock

/dev/sda2 1790136 189264 1491612 12% /boot

tmpfs 808356 12 808344 1% /run/user/1000

23GBになっていますね。

これでやっと [/(ルート)]ディレクトリ以下の領域が 32GBになりました。

Aコースはこれで完了です。

=============================

Bコース 6.新しい VGの作成

Bコースは新規の物理ディスクを特定用途として使うケースでの設計が前提になります。

理由の例としてはこんなところが考えられるでしょうか。

- アーカイブ領域として低速で安価なHDDを使っている

- DBのデータ領域としてハードウェア的に冗長性を持つ高価なストレージである

- 他の用途でディスクI/Oやサイズを圧迫されたくない

いずれにしても「他の領域とは同じように使いたくない」という理由がある場合が多かろうと思います。

ここでは [/dev/sdb]PVを使って新規に VGを作ることにします。

vgcreateコマンド(Create a volume group)を使い、[data-vg] という名前の VGを作ります。

subro@UbuntuServer2404:~$ sudo vgcreate data-vg /dev/sdb

Volume group "data-vg" successfully created

できました。

[data-vg]VGの情報を見てみます。

vgdisplayコマンド(Display volume group information)を使います。

subro@UbuntuServer2404:~$ sudo vgdisplay data-vg

--- Volume group ---

VG Name data-vg

System ID

Format lvm2

Metadata Areas 1

Metadata Sequence No 1

VG Access read/write

VG Status resizable

MAX LV 0

Cur LV 0

Open LV 0

Max PV 0

Cur PV 1

Act PV 1

VG Size <5.00 GiB

PE Size 4.00 MiB

Total PE 1279

Alloc PE / Size 0 / 0

Free PE / Size 1279 / <5.00 GiB

VG UUID S4Wqg5-B8uj-khZ6-dFgq-E608-CQU7-2LrZI9

サイズに関して以下を覚えておきましょう。

| VG Size | VGのサイズ |

| PE Size | PE(Physical Extent)のサイズ このサイズ単位に割当が行われる |

| Alloc PE / Size | LVに割り当て済みの PE数とサイズ 今は 0 |

| Free PE / Size | LVに未割り当ての PE数とサイズ |

Bコース 7.新しい LVの作成

[data-vg]VGの領域を使って新規LVを作ります。

lvcreateコマンド(Create a logical volume)を使って[data-lv] という名前の新規LVを作ります。

以下のコマンドオプションを指定しました。

| -l | 新規LVに割り当てるPE数 |

| -n | 新規LVの名前 |

ここでは [Free PE] にあった 1,279個全てを割り当てて 5GBの LVとします。

subro@UbuntuServer2404:~$ sudo lvcreate -l 1279 -n data-lv data-vg

Logical volume "data-lv" created.

できました。

[data-lv]LVの情報を見てみましょう。

lvdisplayコマンド(Display information about a logical volume)を使います。

LVの指定に [data-lv] とだけするのは誤りで、「 [data-vg] にある [data-lv] 」というように [data-vg/data-lv] とすると出てきます。

(VGが違えば同名の LVを作ることが可能なんでしょうね。やったことないですが。)

subro@UbuntuServer2404:~$ sudo lvdisplay data-vg/data-lv

--- Logical volume ---

LV Path /dev/data-vg/data-lv

LV Name data-lv

VG Name data-vg

LV UUID 4aEk3I-SW26-EruH-3kMl-FClL-LjNO-smrEwO

LV Write Access read/write

LV Creation host, time UbuntuServer2404-1, 2025-04-27 16:59:41 +0900

LV Status available

# open 0

LV Size <5.00 GiB

Current LE 1279

Segments 1

Allocation inherit

Read ahead sectors auto

- currently set to 256

Block device 252:1

できました。

[LV-Path] の [/dev/data-vg/data-lv] は次の作業で使うので覚えておきます。

Bコース 8.LVをフォーマットする

新しい LVをフォーマットして、他の LVと同じ ext4形式のファイルシステムを作成します。

mkfs.ext4コマンドを使っているようでいて、これは [/usr/sbin/mke2fs]ファイルへのシンボリックリンクです。

mkfs.ext4コマンドを使うと、ext4形式を指定した形で mke2fsコマンド(create an ext2/ext3/ext4 file system)が実行されます。

subro@UbuntuServer2404:~$ sudo mkfs.ext4 /dev/data-vg/data-lv

mke2fs 1.47.0 (5-Feb-2023)

Creating filesystem with 1309696 4k blocks and 327680 inodes

Filesystem UUID: 31d7d528-06c7-4b00-9b4a-80e437a329c3

Superblock backups stored on blocks:

32768, 98304, 163840, 229376, 294912, 819200, 884736

Allocating group tables: done

Writing inode tables: done

Creating journal (16384 blocks): done

Writing superblocks and filesystem accounting information: done

フォーマットできました。

Bコース 9.UUIDを使って LVをファイルシステムにマウント

最後はマウントなんですが、ここで UUIDについて一つ。

UUIDとは何かというと Universally Unique IDentifier のことで、各ディスクやその中にある領域に個々に付けられた一意のIDです。

こんな感じで。

これがあると何が良いか、いや、無いと何が困るか。

普段はこれら3台のディスクが動いているとします。

真ん中のディスクがいらなくなったので、外したとします。

こうなるのかな?

と思いきや、

こうなってしまったりするので、問題があります。

物理ディスクが繋がれたインターフェイスの若い順に a/b/c とか自動で割り振ってしまうので、このようにディスクを着けたり外したりする時に思わぬ動作をしてしまうのでした。

ディスクの着け外しが簡単なクラウド環境ではこの問題が顕著に現れるように思います。

そこで、個々の領域を特定できる IDを使ってファイルシステムへマウントすることにより、この問題を回避できるという寸法です。

UUIDの利便性は分かっていただけたでしょうか。

[data-vg/data-lv]LVに付けられた UUIDを確認しましょう。

再び lvdisplayコマンドを使います。

subro@UbuntuServer2404:~$ sudo lvdisplay data-vg/data-lv

--- Logical volume ---

LV Path /dev/data-vg/data-lv

LV Name data-lv

VG Name data-vg

LV UUID s4aEk3I-SW26-EruH-3kMl-FClL-LjNO-smrEwO

LV Write Access read/write

LV Creation host, time UbuntuServer2404-1, 2025-04-27 16:59:41 +0900

LV Status available

# open 0

LV Size <5.00 GiB

Current LE 1279

Segments 1

Allocation inherit

Read ahead sectors auto

- currently set to 256

Block device 252:1

[LV path] の [/dev/data-vg/data-lv] を覚えておきます。

[LV UUID] ではないのでご注意下さい。

blkidコマンド(locate/print block device attributes)を使うとマウント設定に必要なブロックデバイスとしての UUIDを確認できます。

新しいデバイスのUUIDを見る時は root権限で実行します。

subro@UbuntuServer2404:~$ sudo blkid /dev/data-vg/data-lv

/dev/data-vg/data-lv: UUID="31d7d528-06c7-4b00-9b4a-80e437a329c3" BLOCK_SIZE="4096" TYPE="ext4"

ピンク色の箇所が目的の UUIDです。

OS起動時に [/data] にマウントされるよう [/etc/fstab]ファイルを編集し、最後の行を足しています。

# /etc/fstab: static file system information.

#

# Use 'blkid' to print the universally unique identifier for a

# device; this may be used with UUID= as a more robust way to name devices

# that works even if disks are added and removed. See fstab(5).

#

#

# / was on /dev/ubuntu-vg/ubuntu-lv during curtin installation

/dev/disk/by-id/dm-uuid-LVM-52gNrfJZRqmIPs27ajUHG8QDWLBWsooPN4mojYBscZycAzXcpSEKTxYOhvYf3Pi7 / ext4 defaults 0 1

# /boot was on /dev/sda2 during curtin installation

/dev/disk/by-uuid/b2da75ee-a8f8-48a4-99e3-ee266ae143f4 /boot ext4 defaults 0 1

/swap.img none swap sw 0 0

UUID=31d7d528-06c7-4b00-9b4a-80e437a329c3 /data ext4 defaults 0 1

マウントポイントになる [/data]ディレクトリを作ります。

subro@UbuntuServer2404:~$ sudo mkdir /data

マウントは systemdの管理下になっていて、対象の設定ファイル(/etc/fstab)を書き換えたので systemctl daemon-reloadコマンドで今回の変更分を読み込ませます。

subro@UbuntuServer2404:~$ sudo systemctl daemon-reload

何も出ませんが読み込まれました。

これで systemd用の設定ファイルが [/run/systemd/generator/data.mount] として自動作成されました。

ちなみに中身はこのようになっています。

# Automatically generated by systemd-fstab-generator

[Unit]

Documentation=man:fstab(5) man:systemd-fstab-generator(8)

SourcePath=/etc/fstab

Before=local-fs.target

Requires=systemd-fsck@dev-disk-by\x2duuid-31d7d528\x2d06c7\x2d4b00\x2d9b4a\x2d80e437a329c3.service

After=systemd-fsck@dev-disk-by\x2duuid-31d7d528\x2d06c7\x2d4b00\x2d9b4a\x2d80e437a329c3.service

After=blockdev@dev-disk-by\x2duuid-31d7d528\x2d06c7\x2d4b00\x2d9b4a\x2d80e437a329c3.target

[Mount]

What=/dev/disk/by-uuid/31d7d528-06c7-4b00-9b4a-80e437a329c3

Where=/data

Type=ext4

これを systemd startコマンドで開始します。

subro@UbuntuServer2404:~$ sudo systemctl start /data

相変わらず何も出ません。

上手く [/data]ディレクトリにマウントできたか、ファイルシステムとして使えるか確認します。

subro@UbuntuServer2404:~$ df

Filesystem 1K-blocks Used Available Use% Mounted on

tmpfs 808364 1468 806896 1% /run

/dev/mapper/ubuntu--vg-ubuntu--lv 18631360 7122116 10537468 41% /

tmpfs 4041804 0 4041804 0% /dev/shm

tmpfs 5120 0 5120 0% /run/lock

/dev/sda2 1790136 189264 1491612 12% /boot

tmpfs 808360 12 808348 1% /run/user/1000

/dev/mapper/data--vg-data--lv 5070496 24 4792152 1% /data

subro@UbuntuServer2404:~$ ls -ld /data

drwxr-xr-x 3 root root 4096 4月 27 17:15 /data

subro@UbuntuServer2404:~$ cd /data

subro@UbuntuServer2404:/data$ sudo touch aaa

subro@UbuntuServer2404:/data$ ls -l

合計 16

-rw-r--r-- 1 root root 0 4月 27 18:25 aaa

drwx------ 2 root root 16384 4月 27 17:15 lost+found

[/data]ディレクトリとして 5GBの領域を使えるようになりました。

Bコースはこれで完了です。

==========

ディスクを使うのに必ずしも論理ボリュームを使わないといけないわけではないのですが、領域拡張や再利用の点で非常に柔軟に対応ができますので、論理ボリュームは使っておいた方が無難だと思います。

Windows OSのように、Linuxでも Desktop版の OSならば GUIのボリュームマネージャがあるのですが、サーバー管理の観点からはコマンドで一通りできるようになっておくのが良いと思います。

特にクラウド環境ですとディスク操作が多くなると思いますので、慣れておくと良いですね。